Chi ha paura del lupo cattivo? Il lupo, si sa, è una presenza minacciosa a cui ci si dovrebbe avvicinare con estrema cautela quando c’è, ma crea scompiglio anche quando viene semplicemente evocato. La notizia del suo avvistamento corre di bocca in bocca con grande rapidità e le sue fattezze diventano sempre più inquietanti, e mostruose, con il passaparola. C’è anche chi si diverte a “trollare” calcando la mano per fare qualche clic, ma questa è un’altra storia. Il lupo, spesso e volentieri, può essere anche un videogioco. E il motivo di tanta paura sono le sue richieste hardware.

È già successo diverse volte e il copione è sempre lo stesso: chi lo prova in anteprima esprime il suo motivato disappunto, chi legge fa rimbalzare la notizia omettendo i particolari, qualcuno aggiunge farina del proprio sacco e “la ggente” perennemente affamata di poveri cristi da mettere in croce fa il resto, edificando un Golgota a misura di social network e lastricando di zeri i siti che ancora oggi, per qualche motivo, offrono il diritto di voto a chiunque, anche a chi il gioco neanche l’ha comprato, o lo ha fatto soltanto per poter stoccare la propria bocciatura e poi chiedere il rimborso. È così che nascono le leggende metropolitane. L’ultima, recentissima, è il porting da PS5 a PC del remake di The Last Of Us Part I, sulla cui qualità sono fioccati i peggiori giudizi che io abbia letto dai tempi delle shitstorm su Baldo e Cyberpunk 2077. Ma è mai possibile che un gioco tanto atteso, parte di un’operazione commerciale così importante, faccia davvero così schifo? O sarà mica il solito tiro al piccione portato avanti sulla scia di un trend topic sull’altare del SEO? Vediamo di capirci qualcosa.

UN RISCALDAMENTO TROPPO LUNGO

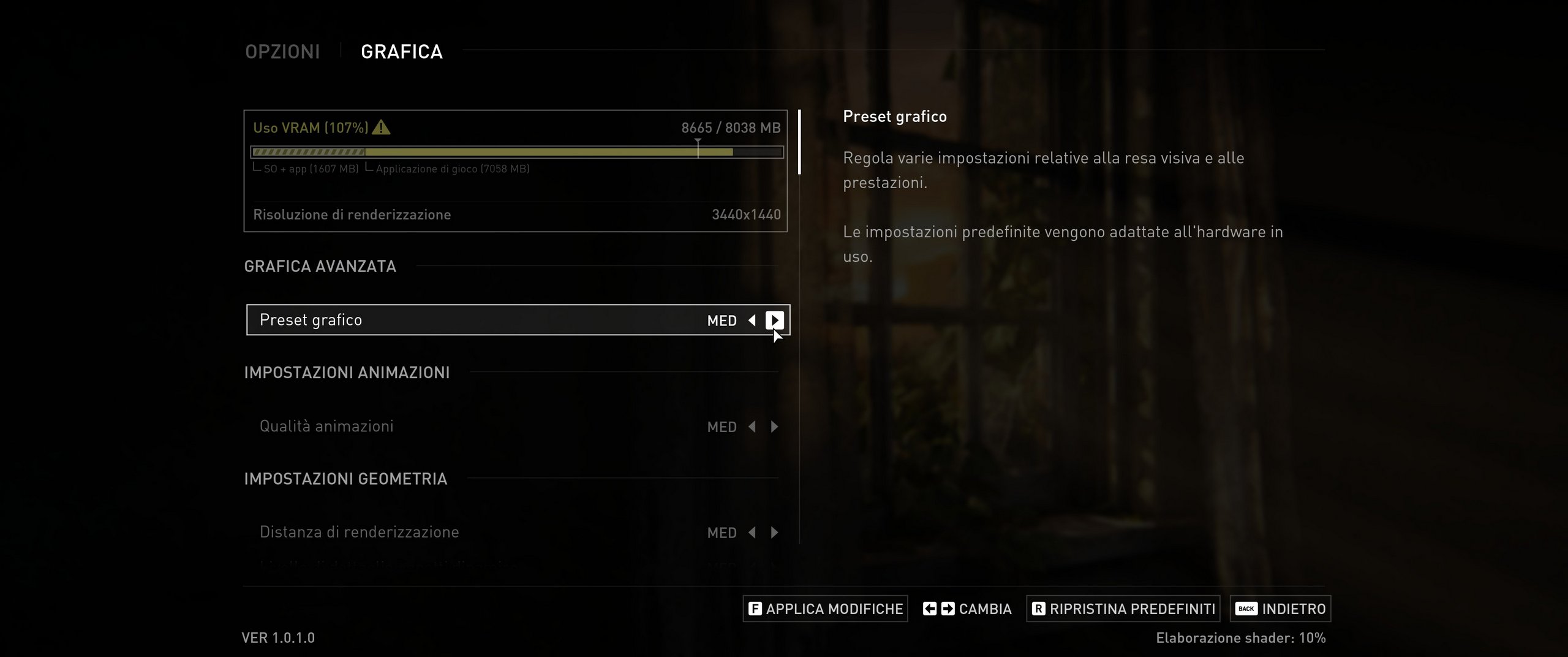

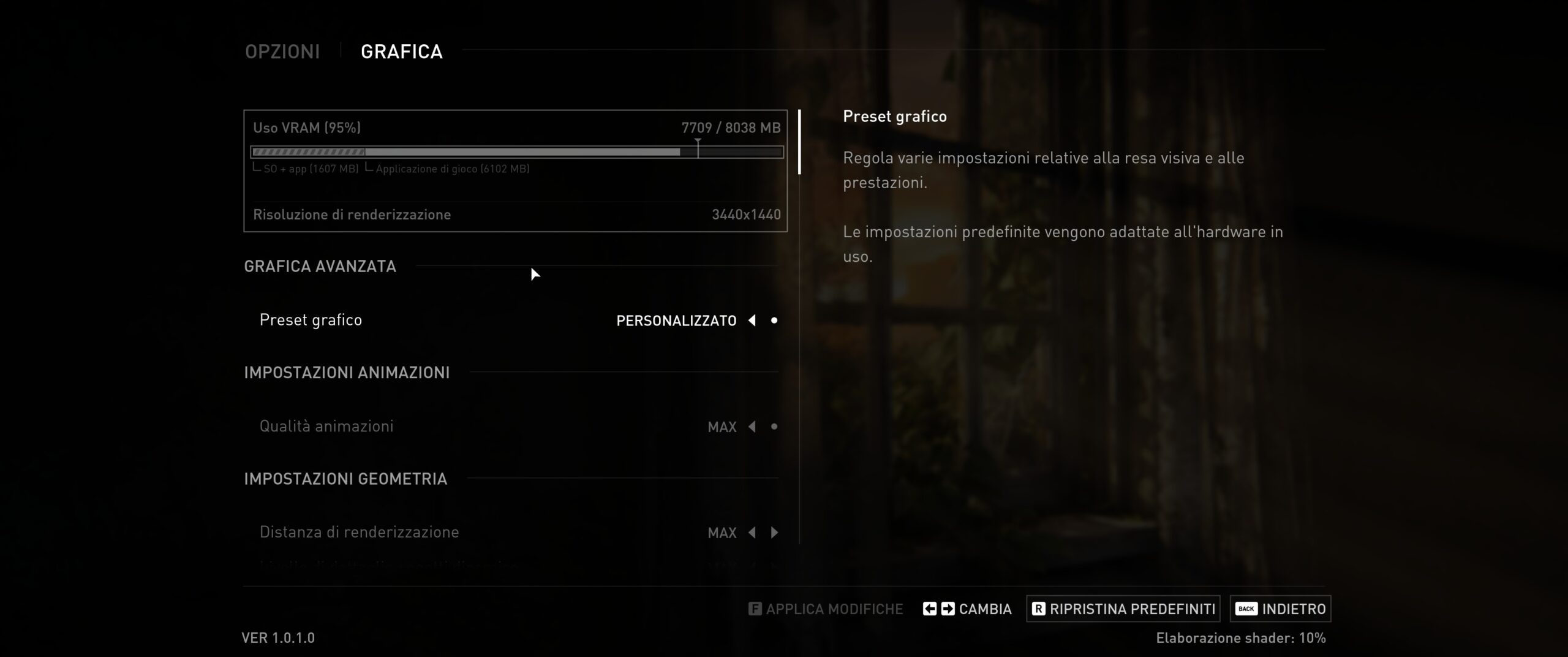

Prima di tutto, chiariamo un concetto. The Last of Us su PC offre un impatto scenico di assoluto prim’ordine: anche nell’amara eventualità di essere costretti a impostare tutti i livelli di dettaglio al minimo, perché la nostra configurazione hardware non permette di fare di più, l’esperienza visiva sarebbe comunque di grande qualità, complessivamente migliore rispetto alle impostazioni “medie” o “alte” di altri giochi, e questo chiaramente impone dei requisiti di un certo peso. In secondo luogo, il gioco permette di modificare un sacco di parametri mostrando in tempo reale le differenze su un’immagine di esempio e, cosa decisamente più importante, calcola in tempo reale l’occupazione della VRAM di ogni nostra singola scelta.

Anche a impostazioni grafiche su Minimo, l’esperienza visiva di TLoU è comunque di grande qualità, complessivamente migliore rispetto alle impostazioni “medie” o “alte” di altri giochi, e questo impone dei requisiti di un certo peso

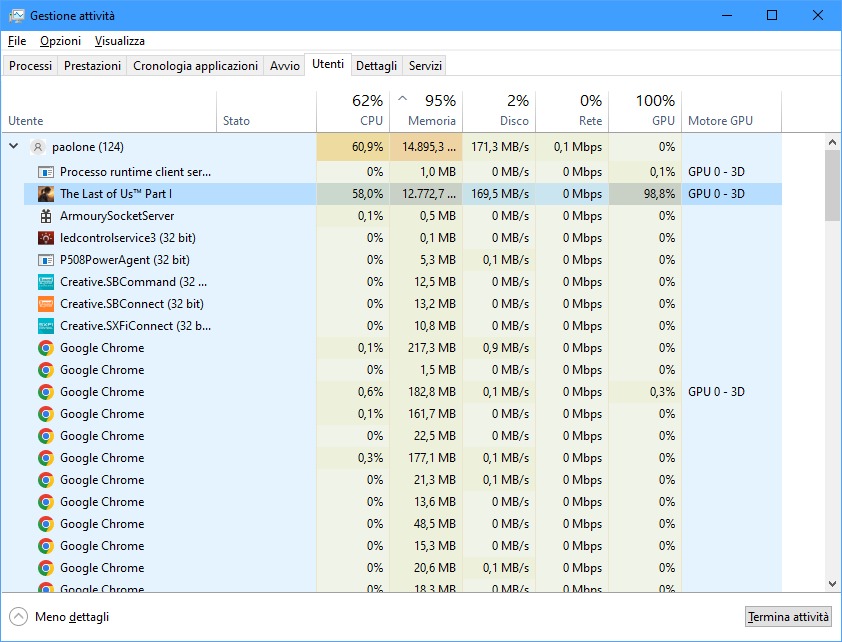

Dalle immagini notiamo come la CPU venga impegnata, su ciascun core logico a sua disposizione, dal 60 al 100% da task riconducibili al gioco. È bene precisare che questo comportamento non può e non deve essere considerato “anomalo” o peggio ancora “pericoloso per la CPU” (come ci è capitato di leggere in simili circostanze), in quanto tutti i processori centrali di AMD e Intel sono progettati per lavorare anche al 100% delle loro possibilità per lunghi periodi di tempo, prevedendo l’abbassamento automatico delle frequenze operative in caso di surriscaldamento. Va da sé che quest’ultimo può avvenire soltanto se il dissipatore montato sulla CPU è inadeguato, o se l’utente ha volutamente disattivato dal BIOS i sistemi di controllo, magari allo scopo di spingere le frequenze oltre le specifiche (overclock, overvolt). È altresì pacifico che, in quest’ultimo caso, sia fortemente consigliabile spingere anche la velocità delle ventole o usare sistemi di raffreddamento a liquido per evitare problemi. E che non si possano imputare a The Last of Us eventuali danni.

La durata del “riscaldamento” del gioco dipende dalla quantità di core e dalla velocità del processore centrale, dalla quantità di RAM disponibile e dal tipo di drive in uso: nel nostro caso è servita un’ora nonostante l’hardware performante

LE PERFORMANCE DI THE LAST OF US PART I

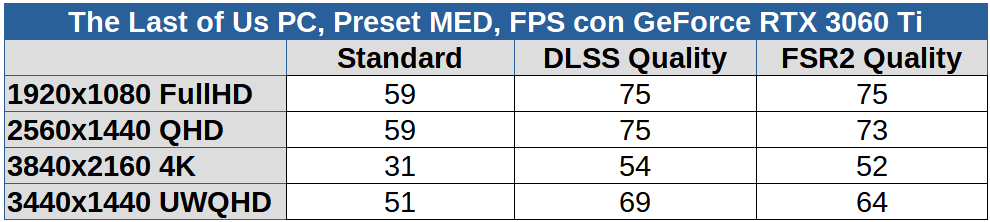

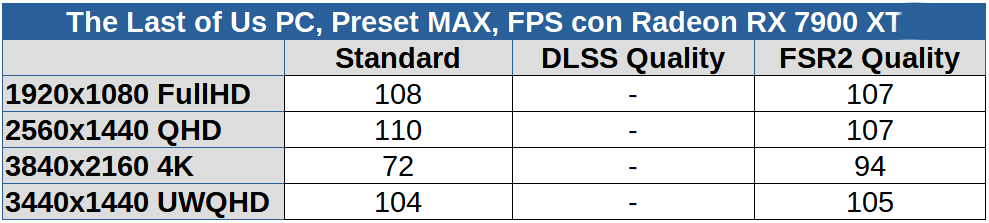

Abbiamo provato The Last of Us su diverse configurazioni, tutte dotate di Windows 11. Lo abbiamo visto all’opera con diverse schede video tra cui una GeForce RTX 3060 Ti con 8 GB di VRAM (350 euro), una Radeon RX 6600 XT con 8 GB (350 euro), una GeForce RTX 4070 Ti con 12 GB (900 euro, per cui ringraziamo MSI) e una Radeon RX 7900 XT con 20 GB (890 euro, per cui ringraziamo AMD). Di tutte queste, l’unica che ci ha permesso di portare tutti i dettagli a livello Ultra (il massimo possibile) è proprio l’ultima, in virtù della sua quantità smodata di VRAM. Neanche i 12 GB presenti sulla RTX 4070 Ti ci hanno permesso di andare oltre a ‘Max’ (che poi corrisponde bene o male al tradizionale ‘High’ degli altri giochi) perché le impostazioni ‘Ultra’ pesano la bellezza di 11.646 MB (più di 11 GB) e quindi serve una scheda con almeno 16 GB di VRAM per poterci stare dentro. È bene ricordare che TLoU non è l’unico processo in esecuzione: quando impostiamo il dettaglio grafico, la barra in alto ce lo ricorda menzionando anche quanta della memoria video è impegnata da Windows e dagli altri programmi, a cui il gioco va banalmente a sommarsi.

Abbiamo testato TLoU su diverse configurazioni: tra GeForce RTX 3060 Ti da 8 GB, Radeon RX 6600 XT da 8 GB, GeForce RTX 4070 Ti da 12 GB e Radeon RX 7900 XT da 20 GB, l’unica scheda video che ci permesso di impostare il massimo della bellezza estetica è stata l’ultima

1) Ryzen 5 5600X + Radeon RX 6600 XT 8GB + 32GB DDR4 + SSD NVME Gen3 + Impostazioni MED:

2) Core i5 11600K + GeForce RTX 3060 Ti 8 GB + 32 GB DDR4 + SSD NVME Gen3 + Impostazioni MED:

3) Core i5 12600K + GeForce RTX 4070 Ti 12 GB + 32 GB DDR5 + SSD NVME Gen4 + Impostazioni MAX:

4) Core i5 12600K + Radeon RTX 7900 XT 20 GB + 32 GB DDR5 + SSD NVME Gen4 + Impostazioni MAX:

Come possiamo notare, il gioco funziona piuttosto bene anche con le schede video di fascia media (RX 6600 XT, RTX 3060 Ti), permettendo un’esecuzione fluida in Full HD anche se il processore non è nuovissimo. Con l’upscaling di DLSS o FSR2 si gioca fluidamente a 4K, senza perdite di qualità visiva. Si noti che per questi test abbiamo usato le versioni dei driver indicati da AMD e Nvidia per il gioco. Certo, ci saremmo aspettati un framerate superiore su schede video come le Radeon RX 6600 XT o le GeForce RTX 3060 Ti, ma non dimentichiamoci che si tratta di un titolo con una grafica particolarmente elaborata e che, in fin dei conti, quelle sono due schede di fascia media della generazione precedente, destinate – di fatto – a diventare una sorta di ‘entry level’ nell’immediato futuro.

LA QUALITÀ VISIVA

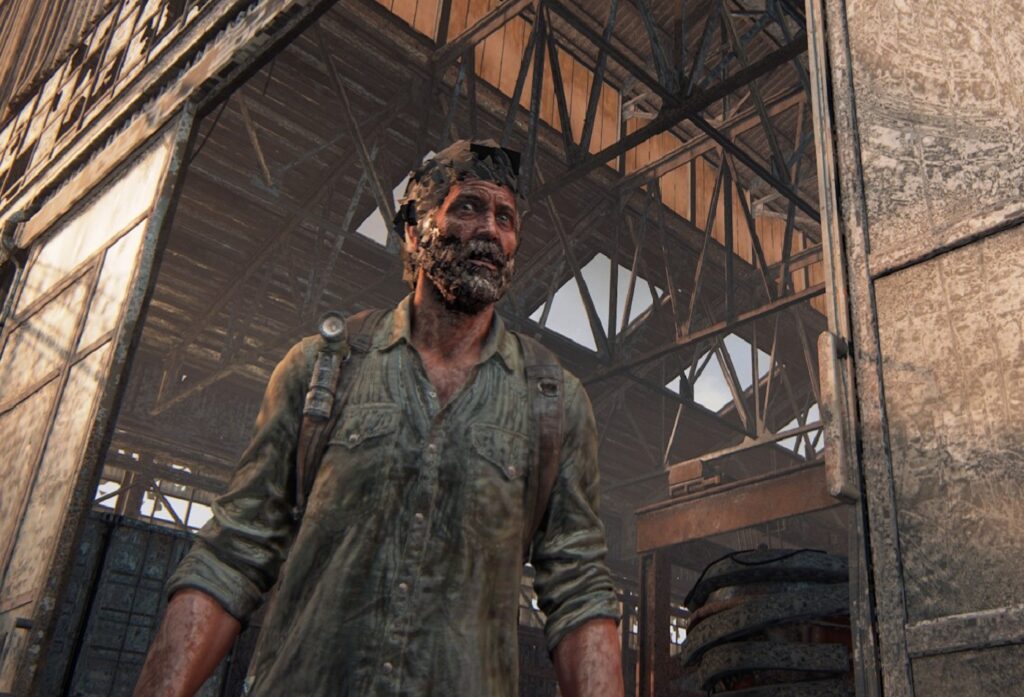

La versione PC di The Last of Us prometteva di essere quella dall’impatto grafico più elaborato e indubbiamente è così. Per poter valutare serenamente la qualità visiva occorre aver atteso pazientemente fino al termine dell’elaborazione iniziale degli shader, operazione finalizzata a ‘cucire’ le routine grafiche del gioco sulla GPU in uso. Ecco una carrellata di screenshot del gioco a 4K, con le quattro impostazioni rapide Ultra, Max, Med e Min. Screenshot staccati con la Radeon RX 7900 XT a 4K, le occupazioni di memoria si riferiscono a questa risoluzione. Preset Ultra, visualizzazione standard

Preset Ultra, visualizzazione standard

Questo è il massimo che potete ottenere dal gioco, con la massima definizione delle texture e la miglior gestione delle luci e delle ombre. Si notino soprattutto i riflessi nelle pozzanghere e l’ombreggiatura sugli elementi, non ultimo il personaggio principale. Richiede 11,6 GB di VRAM e solo le schede di fascia più alta, con almeno 16 GB di VRAM, possono permettersela.

Preset Max, visualizzazione standard

Preset Max, visualizzazione standard

Ombre e riflessi leggermente meno precise che, però, ci permettono un aumento del framerate rispetto al preset Ultra del 10% circa, per di più occupa “solo” 9,5 GB di VRAM. Di fatto è visivamente indistinguibile dal preset superiore ed è l’impostazione che consigliamo vivamente di usare a chi ha una scheda video di fascia alta.

Preset Med, visualizzazione standard

Preset Med, visualizzazione standard

Texture ed effetti sono ancora di alto livello, ma se osserviamo bene i riflessi, notiamo che sono sensibilmente più sfocati rispetto all’impostazione Max. Da notare che il framerate è molto spesso comparabile all’impostazione Max. Occupa 8 GB di VRAM ed è l’impostazione da scegliere sulle schede che hanno questo quantitativo di memoria. In base alla risoluzione impiegata, poi, è possibile salire a ‘Max’ su singole voci. Ricordiamo che ‘sforare’ del 10-15% rispetto al limite non comporta gravi problemi di framerate.

Preset Min, visualizzazione standard

Preset Min, visualizzazione standard

Qui la situazione si fa un po’ più pesante, ma senza esagerare. I riflessi e le pozzanghere spariscono del tutto, la trama della camicia del protagonista si fa indistinta, le venature del pezzo di legno che porta in spalla quasi indistinguibili, le texture come il muro di mattoni lì davanti perdono profondità. Siamo a 6 GB di VRAM occupati a 4K e questo è il livello di dettaglio da usare su schede prive di consistenti quantità di memoria.

Preset Ultra, visualizzazione FSR 2

Preset Ultra, visualizzazione FSR 2

Una mano consistente a elevare il framerate del gioco ci arriva dalle tecniche di upscaling DLSS e FSR2 (la qualità visiva tra le due è ugualmente eccellente, inutile fare confronti), che in pratica renderizzano l’immagine a una risoluzione inferiore e poi aggiungono dinamicamente i dettagli mancanti. Soprattutto se intendete giocare a 1440p o a 4K, noi consigliamo vivamente l’uso di DLSS o di FSR2 e mantenere, se possibile, la modalità “Qualità”. Se confrontiamo questa immagine con quella del preset Ultra in modalità Standard, sono del tutto indistinguibili tra loro. L’upscaling fa anche risparmiare VRAM.

THE LAST OF US PART I PC, ALCUNI “TRUCCHI”

In attesa che i programmatori sfornino qualche patch per comprimere maggiormente le texture o trovare un modo per ridurre l’occupazione della VRAM, possiamo ricorrere a qualche strategia per scendere a compromessi accettabili, aumentando sensibilmente il framerate senza perdere qualità visiva. In fondo abbiamo scelto la master race per un motivo, no? Quindi:

1 – Settiamo il desktop di Windows alla risoluzione che ci serve: spesso e volentieri i PC usano risoluzioni più alte del necessario, salvo poi raddoppiare gli elementi sul desktop per renderli più leggibili. È inutile tenere lo schermo a 4K e gli elementi al 200%, piuttosto lo si metta in Full HD e al 100%. A quel punto sarà possibile avviare TLoU in Full HD senza l’overhead della VRAM usata da Windows;

2 – Nella sezione Schermo delle opzioni del gioco, attiviamo DLSS o FSR2 – a seconda di ciò che è supportato dalla nostra scheda video – in modalità Qualità. Il rendering avverrà a risoluzione leggermente inferiore, con notevole risparmio di sforzi per la GPU e di occupazione della VRAM, lasciandoci spazio per ulteriori abbellimenti;

3 – nella sezione Grafica delle opzioni, alziamo pure di un livello i dettagli delle texture di sfondi e personaggi, bilanciandoli con un dettaglio inferiore di effetti e oggetti dinamici;

4 – abbassiamo il livello di risoluzione (a metà o addirittura un quarto) di alcuni elementi come le sfocature e i riflessi: risparmieremo un sacco di calcoli senza un evidente peggioramento della qualità visiva. Magari riduciamo l’effetto “grana della pellicola” di qualche tacca. Comporta un risparmio moderato ma sempre meglio di niente;

5 – se non abbiamo a disposizione FSR2 o DLSS, sblocchiamo la risoluzione di rendering e abbassiamo dal 100% all’80% o anche meno per risparmiare calcoli e aumentare il framerate. Al contrario, se vogliamo aumentare un po’ la definizione, invece di salire con la risoluzione video (per esempio da Full HD a 2K), manteniamo invariata la risoluzione e aumentiamo piuttosto quella di rendering dal 100% al 140% (questa cosa non si può fare con DLSS o FSR2 attivi).

…E QUESTO? È UN BUG!

Sui social network (anche da eminenti siti della concorrenza) sono stati mostrati screenshot orripilanti che ritraggono TLoU per PC con una grafica ampiamente al di sotto del livello minimo possibile, con colori slavati tendenti al grigio e personaggi dai tratti quasi deformi. È capitato anche a noi, ma è bastato chiudere il gioco e riavviarlo perché tutto tornasse alla normalità. Capiamo l’esigenza di fare clickbaiting sulle proprie pagine, ma spacciare un evidente bug per una feature ci sembra un tantinello esagerato.